僕が一年ほど前から度々高密度指向性3次元ディスプレイの話をしていたのをご存知の方もいるかもしれない。

これはAono.Yさん【36視差】裸眼3Dディスプレイを自作してみた【立体映像】を見てこれを自分たちでもやってみようという灘校パソコン研究部内で立ち上がったプロジェクトに伴うものでした。このプロジェクトは一応はKOF2011で静止画のみという形式で成功したが、僕の現役引退に伴い終了となった。

なお、このプロジェクトではAono.Yさんからアドバイスを頂きました。Aono.Yさんのアドバイスなしでは完成までは至らなかったでしょう。この場の借りて御礼申し上げます。

ただ、これはあくまでもハードウェアの製作やソフトウェアの実装が中断したということで、個人的に理論面はかなり改善を行い、既存の見た目の迫力がない、視点が矛盾するなどの問題は机上ではほとんど解決した。きちんとした形で発表出来れば良いのだが、そんな気力も時間もないのでまだおこなっていないが、アイデアは後輩に口頭で伝えたので、もしかすると後々に灘校パソコン研究部から発表されるか、部から消えていれば僕が大学に入ったら発表するかもしれない。といっても、そこまで画期的というわけでもないですし、あまり既知のものと変わらないのでここでLytroを交えてそれに関しても触れます。

僕が考案している三次元ディスプレイはハードウェアとしてはREGZA GLに近い、GLの解説ページにある「斜めレンズ+垂直画素」の方法で、部で製作に成功したのはこの形式。この技術は基本的に海老沢廣喜先生、高木康博先生による「72指向性画像を表示する薄型三次元ディスプレイ*」とほぼ同等で、利用するモニターは同じT221、レンズは資料には明記されていなかったが一般的な手法で購入できる30LPIのレンチキュラーレンズをもとにソフトウェア側で誤差の修正を行い実現した。

* 海老沢廣喜,高木康博,”72指向性画像を表示する薄型三次元ディスプレイ”,3次元画像コンファレンス2004,工学院大,2004年6月.

だが、この論文、またここから派生した技術には大きな問題点があった。ここには「視差」という概念自体を持ち込んだゆえの問題が起こる。

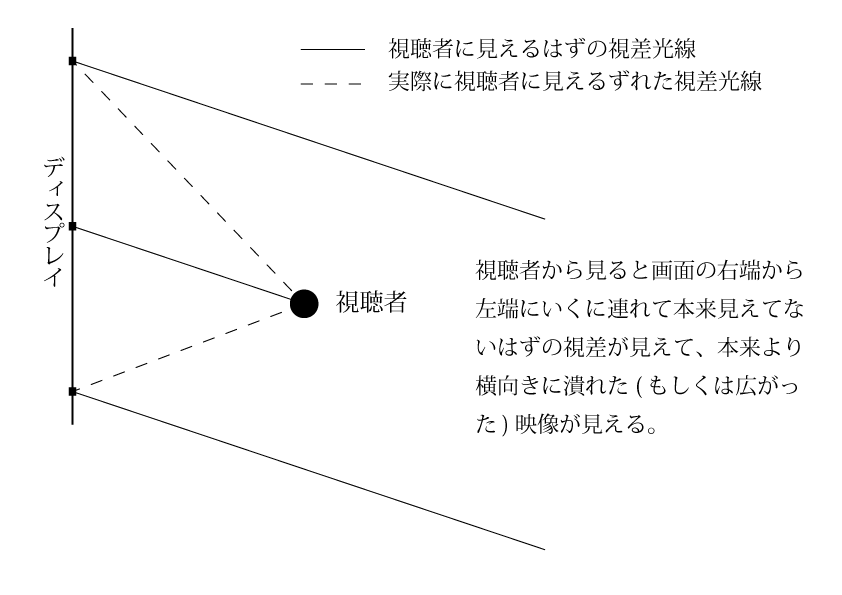

この画像だと視聴者がやたら近いのでかなり大げさだが、視野角をモニターの1度弱に収める距離でないときちんと1視差にならない。ただしレンズによってその度数は大幅に異なるが、右目と左目とで違う視差を見せるという前提条件を満たすと考えると1視差の画像がそれ以上広がってしまうのは避けたい。

また、画面に対してあまり横にずれると画面縁の視差がループしてしまう問題もあるが、こちらはハードでしか解決できない。なお、視聴者が一人であればカメラで目の位置をトラッキングすればある程度解決できるのだが、それだと高密度指向性三次元ディスプレイのメリットである複数人で臨場感のある三次元映像が楽しめるというメリットがかき消されてしまう…(;・∀・)

さて、この問題を解決すべく、ヒントを得たのがホログラフィーだ。っていうかほぼまんまホログラフィーだ…といても厳密には違う…?(教えて、誰か物理詳しい人)この高密度指向性三次元ディスプレイを実用化する際に、一般的に多数の普通のカメラで撮影した映像を合成する(もしくはREGZA GLの様に二視差の三次元映像から生成する)という暗黙の前提条件があるため、この「視差」という概念は消し去れないだろう。ただ、我々のプロジェクトはそんな36台もほぼ同スペックのカメラを並べて、カメラアレイを作り、そこからリアルタイム合成などということはコスト的に不可能なのは重々承知していたので3DCGがベースだった。

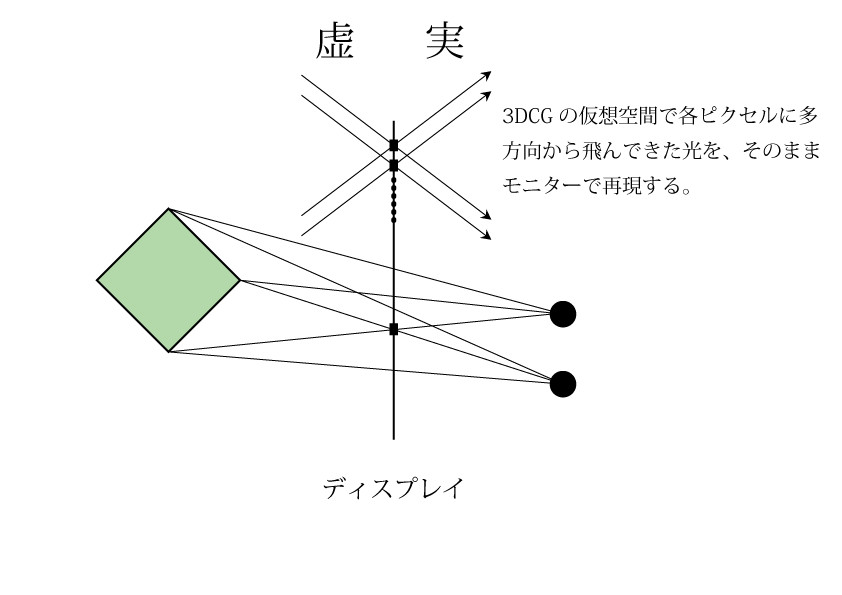

ホログラフィーを多少足りとも知っている人はピンと来たかもしれないが、3DCG空間ではカメラの数も仕様も自由なのを利用して、各ピクセルごと(といっても縦向きは同一なので横方向のだけだが)にカメラを置いてレンダリングするのた。つまりこういうことだ。

レンダリング回数400回超!!!んな無茶苦茶なと思うかもしれないが、一回一回のレンダリングのピクセル数はその分減るのでピクセルシェーダーの負荷はクリア、頂点シェーダーに関しては普通に計算させると重複がかなり出るが、グラフィックパイプラインを工夫してクリア、問題はジオメトリシェーダーに関しては…まあ原理上仕方がない。

といっても、これはなかなか実装が面倒な上に、画面より手前にあるもの、つまり一番臨場感を感じる「浮き出て来るもの」が表現できない。いろいろ考えた挙句、最終的には超単純な結論に落ち着いた。…が、まあLytroとつながるのはここからなのでそれは後にということで。僕がどんな方法を思いついたかわかった人はTwitterなりでリプライくれればお返事します。

そして、この3DCG空間でのデータの取る方法がまさに「Lytro」なのだ。

ピントは後から合わせればいい──米企業、画期的なカメラを製品化へ – ITmedia ニュース

Science Inside | Lytro – Lytro公式の構造図

Lytroの仕組みはここで上記のページで解説が行われているが、ここでも簡単な図を載せる。

なお、カメラ前方のレンズは今回の話では重要ではないので省いた。

そう、先ほど仮想空間で実現しようとしていたことを、現実でやっているのだ。これだけ見ると、Lytroと高密度指向性三次元ディスプレイを組み合わせればすごい映像システムが出来るかの様に思えるが、実際はうまくいかない。

先の虚空間と実空間の図を見なおしてみてほしい。虚空間と実空間はそのままのサイズでつながっている。つまり、

仮想空間でのカメラアレイの幅 = 実空間でのディスプレイの幅

となっている。Lytroの場合、このマイクロレンズアレイの幅は実質カメラのレンズの有効口径と同じなのでたかだか数センチとなってしまう。数センチだと、ほとんど視差がなく、臨場感のある映像を出すのには不十分だ。

ただ、これを発展させて、幅50cmにも渡るカメラを作って撮影すればリアルタイムで高密度指向性三次元ディスプレイに表示することができるかもしれない。幅50cmであれば個人用は無理でもテレビ局内などでの利用は可能なのではないのだろうか?

ただ、そこまでして高密度指向性三次元ディスプレイを普及させるメリットというのが消費者に見えてこないですね…(現に今の3Dテレビでも行けてないのに)